近日,北京中关村学院组织开展了新一期 Paper Sharing 学术交流活动,面向全院学生公开分享前沿人工智能领域的重要问题。其中,信息引擎项目成员张延智同学作为主讲人受邀进行报告讲解,以“强化学习( RL )在大语言模型( LLM )中的应用”为主题,系统解析了强化学习核心原理在现代大模型设计中的关键作用,引发了在场师生的广泛关注与深入讨论。

活动背景

为推动学院内部科研氛围建设,加强学生之间的知识共享与学术交流,北京中关村学院近期启动 “ Paper Sharing ” 系列活动,鼓励学生围绕所关注的前沿论文、自主研究方向开展课堂外分享,帮助同学们拓宽视野、深入专题。

活动初期由学院统一发布通知,面向各项目组与研究小组开放分享机会。经项目组推荐与学院评审筛选,张延智同学被确定为此次主讲人之一,以其在强化学习与大语言模型交叉领域的持续研究经验,为全院同学带来高质量分享内容。

分享内容概览

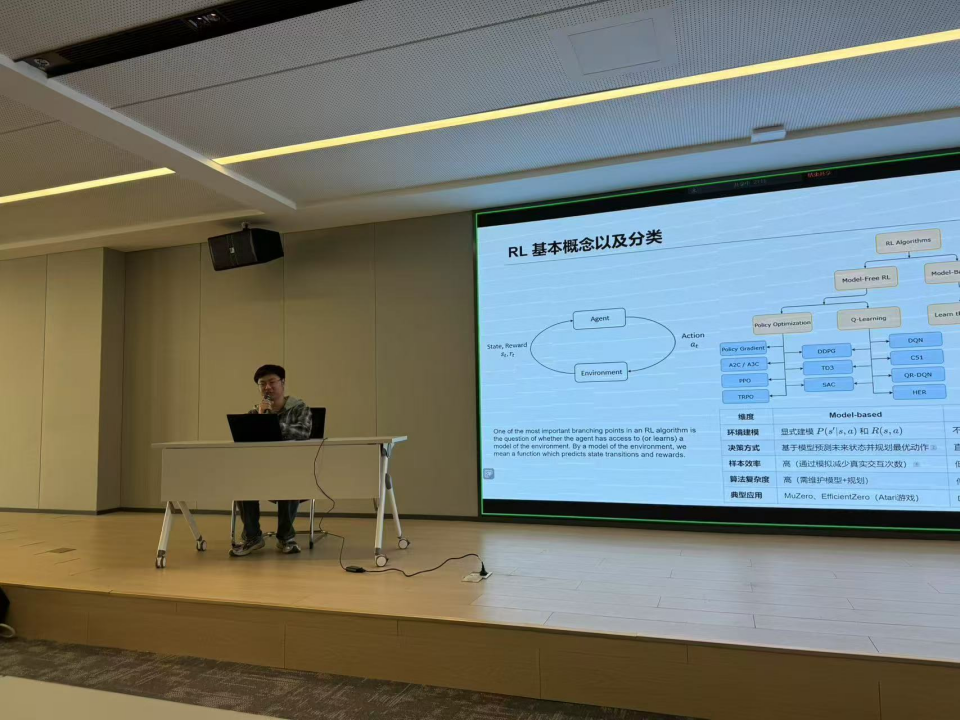

在本次分享中,张延智同学围绕 “强化学习( Reinforcement Learning, RL )在大语言模型( Large Language Models, LLMs )中的应用” 这一主题展开详细讲解,内容既覆盖了理论基础,也延伸到了前沿探索。他首先回顾了强化学习的基本原理,包括经典的马尔可夫决策过程( Markov Decision Process, MDP )、策略与价值函数之间的关系,以及强化学习中“探索”与“利用”的权衡问题,帮助在场同学搭建起认识框架。

在此基础上,张延智进一步介绍了多种主流策略优化方法,聚焦于策略梯度类算法及其最新变体。他重点分析了 PPO( Proximal Policy Optimization )和 GRPO( Generalized Reward-conditioned Policy Optimization ),并通过实际案例说明它们如何在大模型训练中提升策略鲁棒性与收敛效率。

接着,他深入探讨了近年来备受关注的大语言模型对齐技术( Alignment ),阐述了强化学习在实现模型“与人类期望一致”方面的独特优势。在这一部分,他详细解析了包括 RLHF( Reinforcement Learning from Human Feedback )、SimPO( Similarity-based Policy Optimization )与 DPO( Direct Preference Optimization )在内的多种对齐路径,并围绕这些方法的训练方式、反馈机制和评估标准进行系统比较。

在分享的最后,张延智以学术前瞻的视角,围绕强化学习在生成式大模型中的最新研究趋势展开深入分析。重点展示了如 DeepSeek-RL1-Zero 多模态人类反馈建模、Logic-RL 强化逻辑推理能力训练方法,以及 DAPO( Direct Alignment Preference Optimization )等先进策略在实际落地中的表现。他结合具体实验结果,从模型性能提升、误差控制与推理一致性等维度进行剖析,充分展现了强化学习对大模型推理能力、多模态理解与工具调用等核心能力的促进作用。

整场分享内容层层递进,脉络清晰,不仅梳理了从基础到应用的完整知识路径,也为在场师生提供了深入理解强化学习与大模型交叉融合的宝贵视角。

在分享结束后的交流环节中,老师们给出了很高的评价,对张延智同学的系统性讲解与技术视野给予了充分肯定。

关于信息引擎项目

📌 信息引擎项目是一个刚刚成立的 AI 组织,致力于构建未来的智能系统,我们欢迎所有对系统性学习、跨学科探索与工程实践感兴趣的同学加入我们,一起构建与推动更多有深度、有影响力的学生主导项目!

我们强调“对内成长、对外输出”,鼓励每一位参与者既是学习者,也是创造者和传播者。

信息引擎项目将持续推动知识共享与技术传播,为更多同学搭建展示与交流的平台。欢迎更多志同道合的伙伴加入我们!

作者:Zhenzhen Ren

排版校对:Zhenzhen Ren